Trägt der Chatbot eine Mitschuld?

KI-Unternehmen zieht Schlussfolgerungen nach Selbstmorden von Teenagern

31. Oktober 2025, 13:40 Uhr

Artikel anhören

Diese Audioversion wurde künstlich generiert. Weitere Informationen

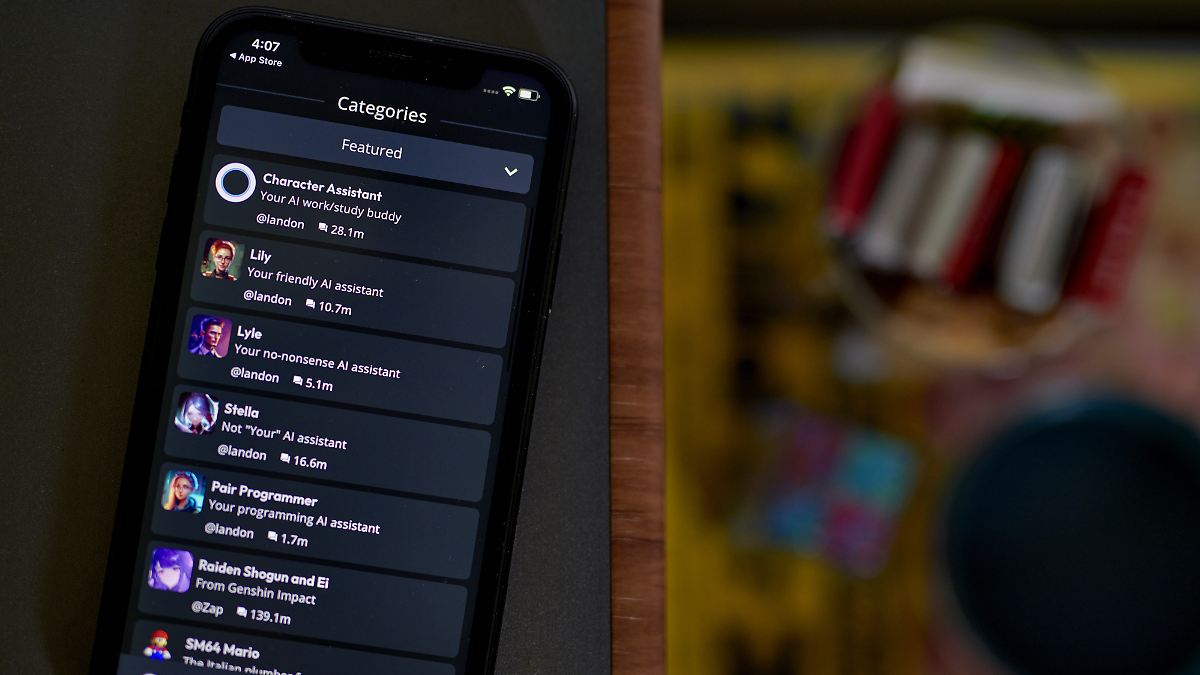

In den USA klagen mehrere Familien, weil sie den Chatbots von Character.AI eine Rolle beim Selbstmord ihrer Kinder zuschreiben. Das Entwicklerunternehmen Character Technologies reagiert nun auf die Vorwürfe.

Der US-Entwickler Character Technologies kündigt große Änderungen an, um junge Menschen bei der Interaktion mit ihren KI-Chatbots von Character.AI besser zu schützen. Künftig sollen Nutzer unter 18 Jahren nicht mehr unbegrenzt Chat-Gespräche mit durch künstliche Intelligenz erstellten Charakteren führen können, teilte das Unternehmen mit.

Die neue Regelung soll demnach am 25. November in Kraft treten. Bis dahin ist die Zeit für solche Chat-Gespräche zunächst auf zwei Stunden pro Tag begrenzt. Neben anderen Maßnahmen wird auch eine neue Altersverifizierung eingeführt. Auch Jugendliche sollen das Tool weiterhin nutzen können, allerdings nicht mehr für offene Chat-Gespräche, sondern zum Erstellen von Videos oder Streams.

Selbstmordklagen

Im vergangenen Jahr verklagte eine Mutter im US-Bundesstaat Florida das Unternehmen, weil sie es für den Selbstmord ihres 14-jährigen Sohnes verantwortlich machte, berichteten US-Medien. Der Teenager soll zuvor intensiv einen der Chatbots des Unternehmens genutzt haben.

- Bei Suizidgefahr: Rufen Sie 112 an

- Deutschlandweites Depressions-Informationstelefon, gebührenfrei: 0800 33 44 5 33

- Telefonische Beratung (0800/111-0-111 oder 0800/111-0-222, Anruf kostenfrei)

- Kinder- und Jugendhotline (Tel.: 0800/111-0-333 oder 116-111)

- Deutsche Depressionshilfe (Regionale Krisendienste und -kliniken, Tipps für Betroffene und Angehörige)

- Deutsche Depressionsliga

Im September reichten die Familien von drei weiteren Minderjährigen in den Bundesstaaten Colorado und New York Klage gegen Character Technologies ein. Sie werfen dem Unternehmen außerdem vor, dass Character.AI eine Rolle beim Selbstmord oder Selbstmordversuch ihrer Kinder spiele.

Zur Begründung der neuen Maßnahmen erklärte Character Technologies nun, man reagiere auf die veränderte Situation im Umgang junger Menschen mit KI. Zuletzt gab es Meldungen und Anfragen von Aufsichtsbehörden dazu, auf welche Inhalte Teenager in Gesprächen mit KI stoßen könnten und wie sich offene Chat-Formate generell auf sie auswirken – auch wenn die Filter richtig funktionieren.

Debatte über den Einfluss von KI

Die Rolle von KI für die psychische Gesundheit und Sicherheit junger Menschen wird in den USA zunehmend kontrovers diskutiert. Ende August reichten Eltern eines US-Teenagers, der im April Selbstmord begangen hatte, Klage gegen die ChatGPT-Entwicklerfirma OpenAI ein. Nach Bekanntwerden der Klage kündigte OpenAI verbesserte Maßnahmen zur Suizidprävention an.

Gleichzeitig räumte das Unternehmen ein, dass die bisherigen Vorkehrungen, die Nutzer unter anderem an eine Beratungshotline verwiesen, bei längeren Gesprächen mit ChatGPT versagen könnten. Es ist dann möglich, dass die Software unerwünschte Antworten liefert.